Jak oznaczać treści generowane przez AI? Pierwszy projekt europejskiego kodeksu

17 grudnia 2025 r. Komisja Europejska opublikowała pierwszy projekt kodeksu w zakresie oznaczania i etykietowania treści generowanych przez sztuczną inteligencję. Dla rynku treści cyfrowych i prawa własności intelektualnej oznacza to nowe wyzwania w zakresie licencjonowania, weryfikacji oryginalności utworów oraz odpowiedzialności podmiotów publikujących materiały AI. Tekst sugeruje, że praktyczne wdrożenie nowych obowiązków nie będzie proste - pisze Natalia Basałaj, radca prawny, Kancelaria Hansberry Tomkiel.

Dokument (dalej: „projekt”)powstał w wyniku szerokich konsultacji publicznych oraz prac dwóch wyspecjalizowanych grup roboczych. Jak wskazano we wstępie, stanowi przede wszystkim punkt wyjścia do dalszych udoskonaleń proponowanych rozwiązań.

Celem kodeksu jest wsparcie dostawców oraz podmiotów wdrażających systemy AI w wypełnieniu obowiązku transparentności wynikającego z art. 50 AI Act poprzez określenie kluczowych obowiązków i wytycznych dotyczących oznaczania treści generowanych przez AI.

Jednocześnie obecny projekt sugeruje, że praktyczne wdrożenie nowych obowiązków nie będzie proste. Nie wskazuje bowiem uniwersalnych technologii gwarantujących skuteczność sugerowanych oznaczeń treści generowanych lub modyfikowanych przez sztuczną inteligencję. Nie zapewnia też odporności na nadużycia.

Prace nad kodeksem nadal trwają. Według opublikowanego harmonogramu pisemne opinie uczestników i obserwatorów prac plenarnych można zgłaszać do 23 stycznia 2026 r. Drugi projekt planowany jest na marzec, a wersja finalna na czerwiec 2026 r. Obowiązek oznaczania treści generowanych lub modyfikowanych przez systemy AI zacznie obowiązywać od sierpnia 2026 r.

Czytaj także: Jak oznaczać treści generowane przez AI? KE publikuje projekt kodeksu postępowania

Systematyka obowiązków przyjęta w projekcie kodeksu

Projekt różnicuje obowiązki przyszłych sygnatariuszy: dostawców systemów AI oraz podmiotów wdrażających te systemy w praktyce.

1. Dostawcy systemów AI powinni w szczególności:

- stosować wielowarstwowe mechanizmy oznaczania treści, obejmujące zarówno oznaczenia widoczne dla użytkownika, jak i rozwiązania odczytywalne maszynowo;

- udostępniać publicznie dostępne narzędzia umożliwiające weryfikację pochodzenia treści;

- zapewniać interoperacyjność oznaczeń pomiędzy różnymi systemami i platformami;

- dokumentować odporność stosowanych oznaczeń na usuwanie, modyfikację lub inne formy manipulacji;

- wdrażać ramy compliance obejmujące testowanie, monitoring oraz bieżącą ocenę skuteczności stosowanych rozwiązań.

2. Podmioty wdrażające systemy AI zobowiązane będą do:

- jednoznacznego oznaczania treści typu deepfake od momentu pierwszego kontaktu odbiorcy z materiałem;

- stosowania jednolitej, unijnej ikony sygnalizującej wykorzystanie AI;

- oznaczania treści publicznych, które zostały wygenerowane lub istotnie zmodyfikowane przy użyciu systemów AI.

Obowiązki dostawców systemów AI

Według projektu wiarygodna identyfikacja pochodzenia treści generowanych przez AI wymaga zastosowania wielowarstwowego podejścia technicznego. Sugerowane jest łączenie kilku metod oznaczania, w tym widocznych i niewidocznych dla użytkownika, które mają się wzajemnie uzupełniać. Przykładowo, znak wodny może odsyłać do identyfikatora zapisanego w metadanych, a metadane do informacji utrwalonych w innej warstwie systemowej.

Przewidziano, że dostawcy systemów AI powinni wprost zakazać (w regulaminach, warunkach korzystania lub dokumentacji technicznej) usuwania lub manipulowania oznaczeniami, zarówno przez podmioty wdrażające, jak i osoby trzecie.

Istotnym elementem projektu jest obowiązek zapewnienia publicznie dostępnych uniwersalnych narzędzi weryfikacyjnych (takich jak interfejsy API), umożliwiających sprawdzenie, czy dana treść została wygenerowana lub zmodyfikowana przez konkretny system AI.

Każdy sygnatariusz kodeksu będzie też zobowiązany do opracowania i aktualizowania ram zgodności, obejmujących procesy oznaczania i wykrywania treści AI, stosowania środków technicznych oraz procedur dokumentacyjnych.

Czytaj też w LEX: Korzystanie z treści generowanych przez AI bez twórczego udziału człowieka a odpowiedzialność za naruszenie praw autorskich >

Pozytywnie oceniam fakt, że projekt odwołuje się do zasady proporcjonalności wobec małych i średnich przedsiębiorstw (MŚP), a także tzw. small mid-cap companies, czyli małych spółek o średniej kapitalizacji (podmioty zatrudniające nie więcej niż 499 pracowników, niebędące MŚP) oraz startupów, przewidując uproszczone i mniej kosztowne metody zapewniania zgodności. Zakres tych ułatwień nie jest jednak jasny, a obowiązki organizacyjne według projektu są takie same dla wszystkich przyszłych sygnatariuszy kodeksu.

Projekt kodeksu to kolejny krok w kierunku przejrzystego oznaczania treści generowanych przez AI, ale nadal nie wskazano jednego, skutecznego rozwiązania technicznego, które działałoby na całym rynku i było odporne na nadużycia. Dokument wprost potwierdza ograniczenia technologiczne – według jego treści „żadna pojedyncza aktywna technika znakowania nie jest wystarczająca, aby spełnić wszystkie wymogi prawne”. W praktyce oznacza to, że odpowiedzialność przedsiębiorców prawdopodobnie będzie oceniana nie według zastosowania pojedynczego narzędzia, lecz w oparciu o całość przyjętych procesów: organizację compliance, dokumentację, testowanie oraz gotowość do audytu.

Czytaj też w LEX: Oznaczanie treści wytworzonych z wykorzystaniem GenAI a ochrona prawnoautorska >

Obowiązki podmiotów wdrażających systemy AI

Zgodnie z projektem obowiązek informowania o wygenerowaniu lub zmodyfikowaniu treści za pomocą narzędzi AI powstanie już w momencie pierwszego kontaktu odbiorcy z takim materiałem, niezależnie od tego, czy dotyczy on treści tekstowych, audio czy wideo.

Powinność ta dotyczy nie tylko dostawców systemów AI, lecz także podmiotów wykorzystujących je w praktyce, w tym redakcji czy wydawców. Sposób oznaczenia powinien być dostosowany do formy i kontekstu publikacji, przy czym w przypadku treści artystycznych, fikcyjnych lub satyrycznych oznaczenie nie powinno zakłócać odbioru ani obniżać wartości twórczej utworu. Na obecnym etapie projekt nie wskazuje jednak rozwiązania technicznego dla branży kreatywnej, które pozwalałoby w pełni pogodzić te wymogi.

Moim zdaniem w praktyce obowiązek zapewnienia szkoleń, nadzoru ludzkiego oraz rozbudowanych procedur compliance może okazać się dla wielu przedsiębiorców korzystających z technologii AI istotnie kosztowny i organizacyjnie obciążający, zwłaszcza wobec braku jednolitych narzędzi technicznych i stabilnych standardów rynkowych. Jednocześnie część proponowanych rozwiązań może być uciążliwa także dla odbiorców treści ze względu na nadmiar komunikatów, a w przypadku twórców i artystów – jednak ingerować w formę przekazu lub sposób odbioru utworu.

Czytaj też w LEX: Pracownicze prawa autorskie a dzieła wytwarzane przy pomocy sztucznej inteligencji >

Jedna europejska ikona AI

Projekt kodeksu przewiduje docelowo wprowadzenie jednolitej, ikony UE informującej, czy treść została w całości lub częściowo wygenerowana lub zmodyfikowana przez AI. Kliknięcie ikony ma umożliwiać dostęp do szczegółowych informacji o pochodzeniu materiału.

W załączniku 1 do projektu zaprezentowano cztery przykładowe ikony służące oznaczaniu treści generowanych lub wspomaganych przez AI. Jedna z nich, przygotowana w zwykłej bezpłatnej wersji ChatGPT z grudnia 2025 r., ma minimalistyczną formę i posługuje się oznaczeniem „AI” w dwóch kolorach:

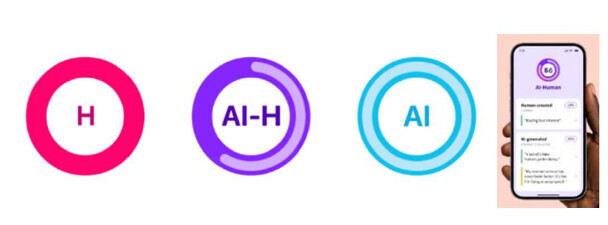

Dużo ciekawszą propozycją jest system opracowany przez studio Artifact, który rozróżnia trzy rodzaje treści: H – w pełni tworzone przez ludzi, AI – w pełni generowane przez sztuczną inteligencję, oraz AI-H – hybrydowe, łączące oba źródła, ze wskazaniem procentowego udziału AI:

Na razie nie istnieje jedna publiczna platforma ani inicjatywa zapewniająca kompleksowe, ogólnounijne oznaczanie treści AI. W praktyce obecne propozycje to prywatne, pojedyncze projekty, a wspólna, jednolita ikona UE wciąż jest opracowywana.

Czytaj też w LEX: Przypisanie autorstwa treści wygenerowanych z wykorzystaniem AI - perspektywa prawnoautorska >

Krajowy organ nadzoru rynku w Polsce – możliwe rozwiązania

Sygnatariusze kodeksu będą zobowiązani do współpracy z organami nadzoru rynku, a także do zapewnienia nadzoru ludzkiego nad procesem etykietowania treści generowanych lub modyfikowanych przez systemy AI.

W Polsce katalog organów odpowiedzialnych za nadzór nad systemami AI nie jest jeszcze ustawowo określony. Projekty ustawy o systemach sztucznej inteligencji (UC71) przewidują powołanie Komisji Rozwoju i Bezpieczeństwa Sztucznej Inteligencji (KRiBSI) jako centralnego krajowego organu nadzoru rynku oraz punktu kontaktowego w zakresie AI Act. Komisja ma monitorować rynek systemów AI, współpracować z organami UE, wydawać wyjaśnienia oraz publicznie dostępne wiążące opinie w indywidualnych sprawach, rozpatrywać skargi dotyczące naruszeń przepisów AI oraz wspierać bezpieczne stosowanie technologii AI.

Projekty przewidują, że w skład Komisji wejdą przedstawiciele publicznych instytucji, w tym prezesa Urzędu Ochrony Danych Osobowych (UODO) oraz prezesa Urzędu Ochrony Konkurencji i Konsumentów (UOKiK). UODO i UOKiK będą realizować swoje kompetencje przede wszystkim w ramach KRiBSI, przy czym będą mogli także prowadzić odrębne postępowania w granicach ustawowych.

Czytaj też w LEX: Odpowiedzialność za szkody spowodowane przez systemy sztucznej inteligencji >

Podsumowanie. Europejski rynek treści AI wchodzi w erę przejrzystości

Od 2026 r. treści generowane lub modyfikowane przez AI w UE będą musiały być wyraźnie oznaczone. Pierwszy projekt kodeksu praktyk UE wyznacza ogólne ramy przejrzystości, odpowiedzialności i bezpieczeństwa prawnego w ekosystemie generatywnej AI, wspierając dostawców i użytkowników w przygotowaniu do wymogów art. 50 AI Act.

Projekt przewiduje różne technologie oznaczania – znaki wodne, metadane czy narzędzia weryfikacyjne – ale żadna z nich nie gwarantuje pełnej odporności na manipulacje ani interoperacyjności. Oznacza to, że odpowiedzialność za spełnienie obowiązków spoczywa przede wszystkim na organizacji procesów compliance przez przedsiębiorcę: właściwym zarządzaniu procedurami, dokumentacji, testowaniu i kontroli zgodności z zasadami transparentności, a nie na samej technologii.

Wciąż pozostaje wiele otwartych kwestii: brak jednoznacznej wykładni art. 50 AI Act dla treści hybrydowych i dzieł artystycznych, dobrowolny charakter projektu oraz brak powiązania zasad oznaczania z sankcjami administracyjnymi czy odpowiedzialnością cywilną.

Dla rynku treści cyfrowych i prawa własności intelektualnej oznacza to nowe wyzwania w zakresie licencjonowania, weryfikacji oryginalności utworów oraz odpowiedzialności podmiotów publikujących materiały AI.

Autorka: Natalia Basałaj, radca prawny, Kancelaria Hansberry Tomkiel

Linki w tekście artykułu mogą odsyłać bezpośrednio do odpowiednich dokumentów w programie LEX. Aby móc przeglądać te dokumenty, konieczne jest zalogowanie się do programu. Dostęp do treści dokumentów LEX jest zależny od posiadanych licencji.